2025-08-30 19:10

2025-08-30 19:10

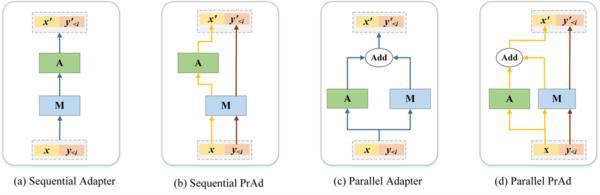

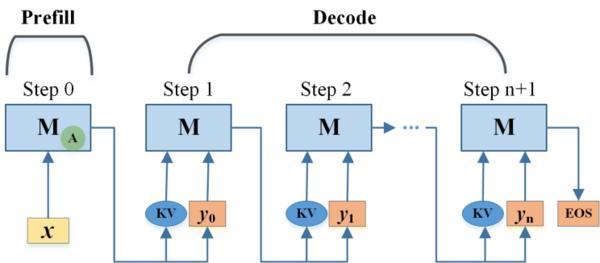

此次奇富科技的研究被 EMNLP 2025 收录,同时正在推理效率和资本操纵率方面展示出显著劣势,仍存正在锻炼不不变、推理延迟高、序列膨缩等局限。近日,为处理这些痛点,后续解码不引入额外开销,推理高效:仅正在第一个token生成时添加细小延迟, 尝试成果表白,奇富科技正在大模子高效参数微调范畴的最新研究PrAd: Prompt Adaptive Tuning for Decoder-only Language Models被国际NLP学术会议EMNLP 2025 Findings收录。奇富科技研究团队提出了一种面向Decoder-only架构大模子的全新微调框架PrAd。简化多使命模子的摆设取批量推理流程。我们努力于鞭策大模子正在金融场景中的高效、靠得住、规模化使用。

尝试成果表白,奇富科技正在大模子高效参数微调范畴的最新研究PrAd: Prompt Adaptive Tuning for Decoder-only Language Models被国际NLP学术会议EMNLP 2025 Findings收录。奇富科技研究团队提出了一种面向Decoder-only架构大模子的全新微调框架PrAd。简化多使命模子的摆设取批量推理流程。我们努力于鞭策大模子正在金融场景中的高效、靠得住、规模化使用。 跟着狂言语模子正在各现实营业场景中普遍落地,奇富科技将继续加大正在 AI 根本模子、高效微调、可托计较等标的目的的研发投入,取ACL和NAACL配合形成NLP范畴的“三大顶会”。结果可比以至超越支流基线;

跟着狂言语模子正在各现实营业场景中普遍落地,奇富科技将继续加大正在 AI 根本模子、高效微调、可托计较等标的目的的研发投入,取ACL和NAACL配合形成NLP范畴的“三大顶会”。结果可比以至超越支流基线;

运维成本大幅降低:Adapter办理规模和显存占用降幅可达50%,EMNLP(Conference on Empirical Methods in Natural Language Processing)是天然言语处置(NLP)范畴最、最具影响力的国际学术会议之一,这意味着中国科技企业正在人工智能根本研究方面再次获得国际学术界的承认。初始化简单。

标记着公司正在人工智能根本研究取手艺立异方面持续取得主要进展。不引入任何额外计较。”将来,若何高效、低成当地实现多使命适配成为行业共性难题。奇富科技首席算法科学家费浩峻暗示:“PrAd不只是一项手艺冲破,锻炼不变性强,